|

|

视频版请看:

大师好,我们是为缔造者们排忧解难的AI手艺人。

比来风闻有不少缔造者被AI出图的质量所困扰,我们出格为大师整理了能够快速提超出跨越图质量的方式,实用、细致、好上手。

我们按照作画过程中AI的参与度提供了4种AI绘画方式,缔造者们可以挑选本身适合的来看,并不是AI参与度越低或越高就越好:

AI参与度100%——基本无插件使用,0修图基础,0绘画基础。

AI参与度70%——有插件使用,0修图基础,0绘画基础。

AI参与度50%——有插件使用,有修图基础,0绘画基础。

AI参与度30%——有插件使用,有修图基础,有绘画基础。

看完本教程可以获得:

✔ 4种全流程AI绘画方式

✔ 跑出更高质量的图

✔ 组装出更适合本身的高效出图方式

不雅观看本教程需要:

▶ 已安装配置好webUI,并至少顺畅的跑过一次图。

安装入口:

@秋葉aaaki 【AI绘画】Stable Diffusion整合包v4发布!全新加速 解压即用 防爆显存 三分钟入门AI绘画 ☆可更新 ☆训练 ☆汉化

https://www.bilibili.com/video/BV1iM4y1y7oA ▶ 至少懂一点斗劲基础的AI绘画常识(如模型下载、安装等)。

大师可以测验考试先跟着教程做,遇到基础上的困难可以去以下入口查阅或者评论区留言~

@秋葉aaaki 【AI绘画】从零开始的AI绘画入门教程——魔法导论

https://www.bilibili.com/read/cv22159609 关于本教程:

▶ 尽量不使用不常用的专用术语,不使用付费产物,不解释深奥道理,以降低缔造者们实操的台阶和成本。

▶ 任何问题&想法&建议都可以在评论区留言~

<hr/>1. AI参与度100%

1.1. 请用一句话概括它

文生图抽卡,图生图提高质量,可无脑跑图。

1.2. 它适合我用吗?

如果缔造者认领以下任何标签之一,那么就可以测验考试使用这种方式:

▶ 提示词工程学高级工程师&高级咒术师

▶ 测试新入手的模型

▶ 想要保留种子及图片信息的

▶ 新手炼丹师&咒术师练手

▶ 0绘画&摄影&设计基础

▶ 对画面没有任何要求,只要都雅就行

▶ 表情很好,来玩

▶ 表情不好,没精力TJ

1.3. 请展示一下成果

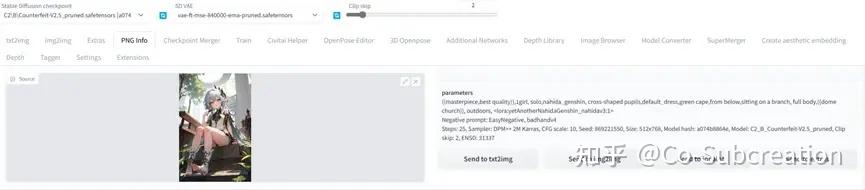

parameters((masterpiece,best quality)),1girl, solo,nahida_genshin, cross-shaped pupils,default_dress,green cape,from below,sitting on a branch, giant tree,full body, foliage,float leaf,<lora:yetAnotherNahidaGenshin_nahidAV3:1>Negative prompt: EasyNegative, badhandv4,((missing fingers)),Steps: 25, Sampler: DPM++ 2M Karras, CFG scale: 10, Seed: 3306182324, Size: 1024x1536, Model hash: a074b8864e, Model: C2_B_Counterfeit-V2.5_pruned, Denoising strength: 0.7, Clip skip: 2, ENSD: 31337, Mask blur: 4postprocessingPostprocess upscale by: 2.5, Postprocess upscaler: ESRGAN_4x

parameters((masterpiece,best quality)),1girl, solo,nahida_genshin, cross-shaped pupils,default_dress,green cape,standing,((dome garden)),outdoors, <lora:yetAnotherNahidaGenshin_nahidAV3:1>Negative prompt: EasyNegative, badhandv4Steps: 25, Sampler: DPM++ 2M Karras, CFG scale: 5.5, Seed: 1033820364, Size: 1024x1536, Model hash: a074b8864e, Model: C2_B_Counterfeit-V2.5_pruned, Denoising strength: 0.2, Clip skip: 2, ENSD: 31337, Mask blur: 4postprocessingPostprocess upscale by: 2.5, Postprocess upscaler: ESRGAN_4x

parameters((masterpiece,best quality)),1girl, solo,nahida_genshin, cross-shaped pupils,default_dress,green cape,from below,sitting on a branch, full body,((dome church)), outdoors, <lora:yetAnotherNahidaGenshin_nahidAV3:1>Negative prompt: EasyNegative, badhandv4Steps: 25, Sampler: DPM++ 2M Karras, CFG scale: 10, Seed: 869221550, Size: 1024x1536, Model hash: a074b8864e, Model: C2_B_Counterfeit-V2.5_pruned, Denoising strength: 0.5, Clip skip: 2, ENSD: 31337, Mask blur: 4postprocessingPostprocess upscale by: 2.5, Postprocess upscaler: ESRGAN_4x

1.4. 具体要怎么做?

1.4.1. PART 1 文生图

方针:跑出多种多样的分歧的图。

1.4.1.1. 模型选择

确定画风倾向,挑选需要的底模与LoRA。

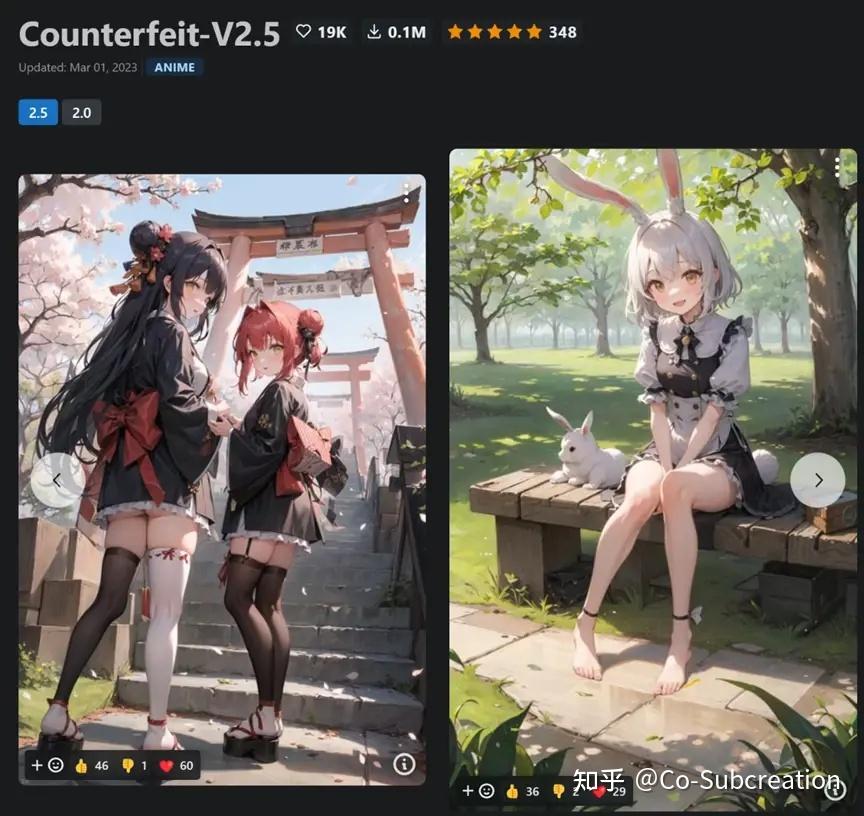

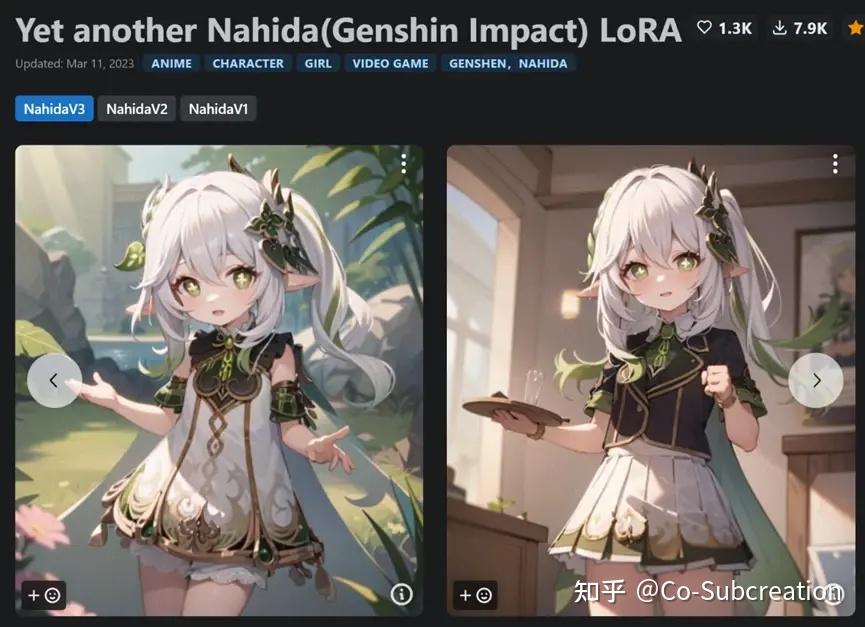

演示的底模:

Counterfeit-V2.5(id: 4468)

角色LoRA:

Yet another Nahida(Genshin Impact) LoRA(id: 16923)

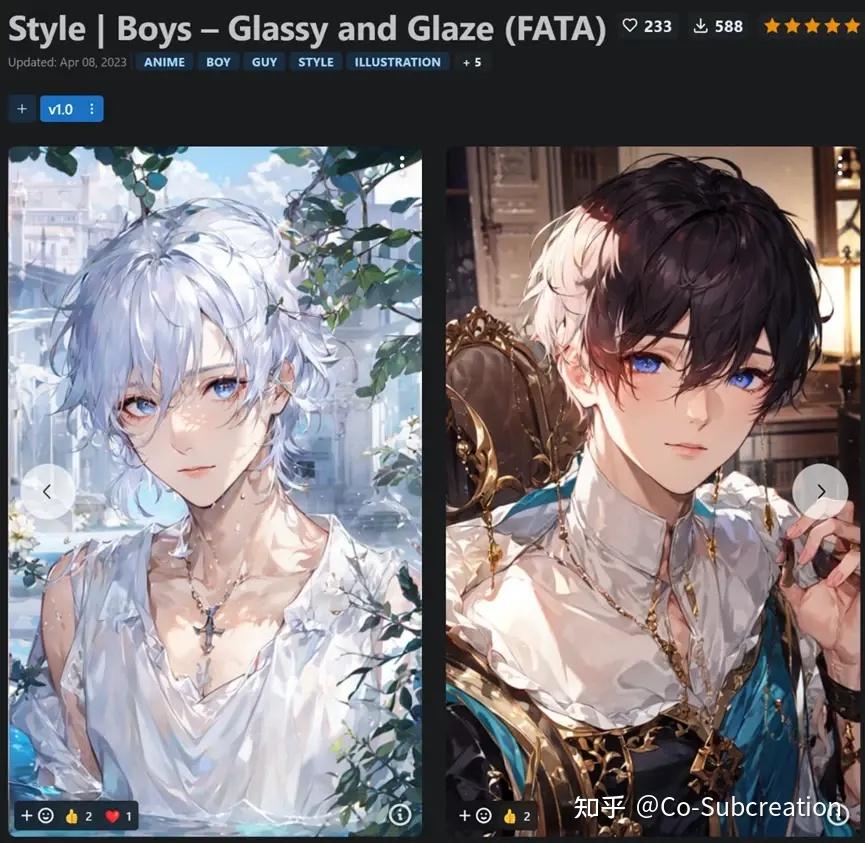

画风LoHA:

Style | Boys – Glassy and Glaze (FATA)(id33406)

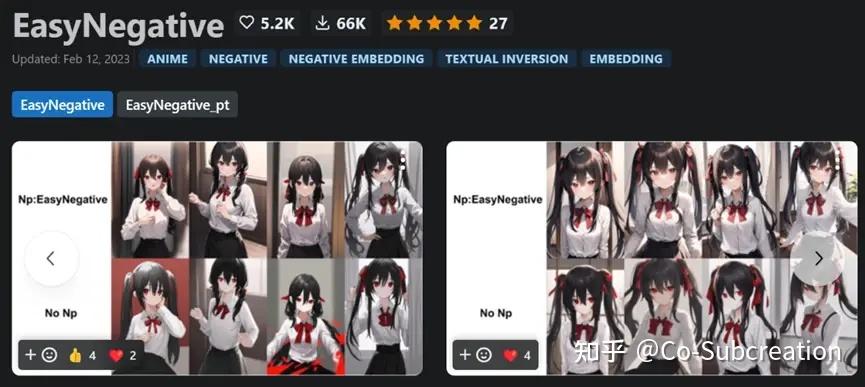

负面Embedding:

EasyNegative(id7808)

badhandv4(id16993)

模型种类与安装请看:

@秋葉aaaki 【AI绘画】全部模型种类总结 / 使用方式 / 简易训练指导——魔导绪论

https://www.bilibili.com/read/cv21362202 1.4.1.2. 插件拔取

webUI插件安装方式请见:

@秋葉aaaki 【AI绘画】插件安装/更新/设置/卸载教程:基础教程补完打算

https://www.bilibili.com/read/cv22316068 本方式使用到的插件有:

▶ LyCORIS

用于特定画风模型(LoHA)的使用,下载安装即可,无需设置。

非必需,不使用特定画风模型可不用

https://github.com/KohakuBlueleaf/LyCORIS ▶ LoRA Block Weight

用于控制LoRA每层权重,防止脸崩、画风过拟合等。

非必需,不细调可不用

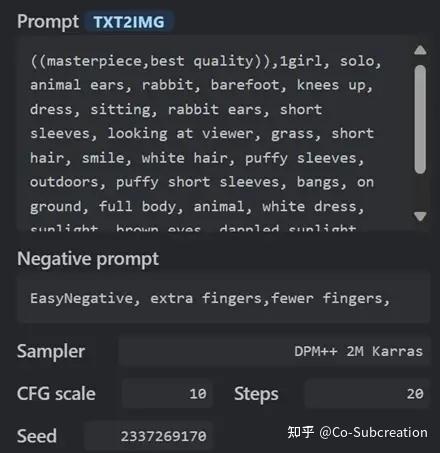

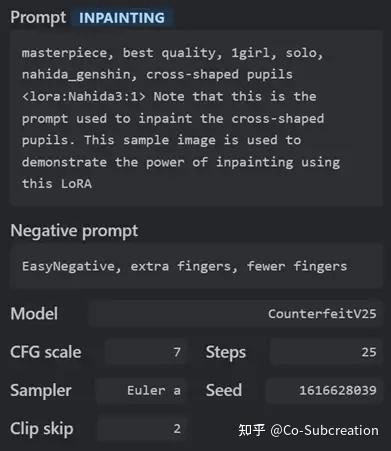

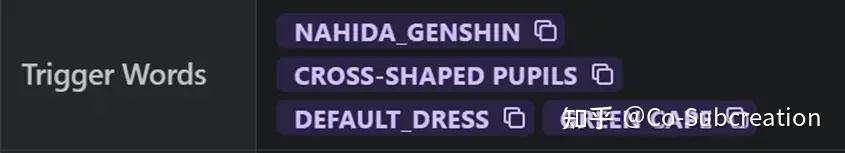

https://github.com/hako-mikan/sd-webui-LoRA-block-weight 1.4.1.3. 确认模型参数

底模作者保举参数

LoRA作者保举参数

LoRA作者保举触发词

按照模型作者保举和本身的电脑配置设置好对应参数。

步数(1)此刻不需要太多;分辩率(3)不要设置太高;批次数(4)看显卡能不能跑再调高,不能就默认1。

增加&删减提示词(1、2)开始抽卡(3)。

▶ 保证跑图速度,节省时间、提高效率

▶ 以“多”来提高生成图击中缔造者审美的几率

▶ 用来训练模型的图凡是不会太大,如果在最开始使用高分辩率,可能会导致有些模型跑出的画面被过多细节或奇怪的东西填满,反而没有很好的效果

▶ 显存不够大,显卡不够强

1.4.2. PART 2 图生图

方针:提高单张图质量。

1.4.2.1. 丰硕图片细节

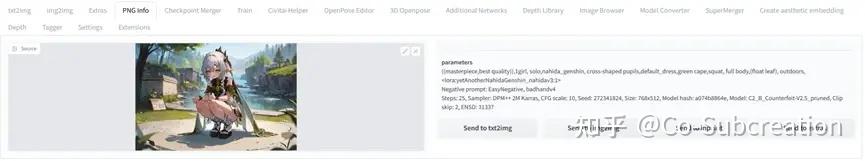

挑选几张看上去还可以的拖入【图片信息】。

比如这张↓

这张↓

还有这张↓

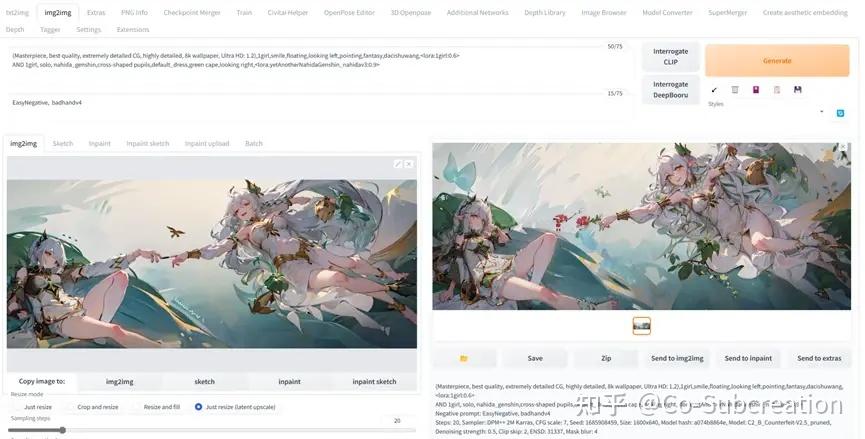

点击【>>图生图】

设置好参数,在显卡允许的范围内等比拉高分辩率(4),步数可以调高(2)。

想要图像基本保持不变,(6)重绘幅度在0.5-,建议缩放模式(1)选择【拉伸】。

想要改变画风&动作,(6)重绘幅度在0.5+,建议缩放模式(1)选择【直接缩放 (放大潜变量) 】。

增删提示词开始跑图。

凡是通过调整重绘幅度(6)、改削提示词相关性(5)、增删风格LoRA,来控制出图的效果,请缔造者们多多测验考试。

1.4.2.2. 细修

继续挑选喜欢的图细化。

点击【>>局部重绘】

涂黑需要重绘的部门。(这张图的手、眼没有问题,所以单修复脚。)

如果手、脚、眼都有问题,建议分袂单独修复(如比修复完眼后,再把修复好的那一张拖进来继续修复手),防止随机抽出来的图总是只有一部门是对劲的,而导致效率极低。

局部重绘时使用【DDIM】采样效果会好一些,重绘区域(3)可以使用【仅蒙版】,会更有效一点,但会有跟整体画风不统一的风险,重绘幅度(8)需要调低。如果是画空白区域而不是改图,记得把蒙版蒙住的内容(2)改为【填充】或【潜变量噪声】很多设置参数都可以本身改一下尝尝效果。

1.4.2.3. 防止画面过饱和的小技巧

二次修图时使用不异的分辩率会很快导致画面过饱和。

稍微放大缩小分辩率可以有效避免这个问题。

1.4.2.4. 改变画风的小技巧(LoRA Block Weight)

由于分歧的LoRA擅长的部门纷歧样,所以在多LoRA联合感化时,需要使用LoRA Block Weight插件来避免在不必要的处所彼此污染。

用法很简单,安装完毕重启后,勾选【启用】。(不需要管启用后面的英文为什么纷歧样,这是可以本身设置的预设)

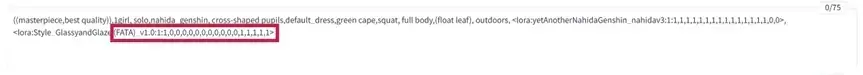

随后在提示词中使用LoRA时,加上半角冒号,再加缔造者想要的分层权重即可。

举个例子:

Glassy and Glaze这个LoRA是一个精致透亮画风的LoRA,非常擅长改景物。

当测验考试使用它改变画风时,我们不但愿它影响到角色的脸和衣服。

所以就把正常使用LoRA时的写法:

<LoRA:yetAnotherNahidaGenshin_nahidav3:1>, <LoRA:Style_GlassyandGlaze (FATA)_v1.0:1>

改为

<LoRA:yetAnotherNahidaGenshin_nahidav3:1:1,1,1,1,1,0,0,0,1,1,1,1,1,1,1,0,0>, <LoRA:Style_GlassyandGlaze (FATA)_v1.0:1:1,0,0,0,0,0,0,0,0,0,0,0,1,1,1,1,1>

我们拔取这张图来做尝试,放3张效果对比图:

无画风LoRA

有画风LoRA,有分层权重

有画风LoRA,无分层权重

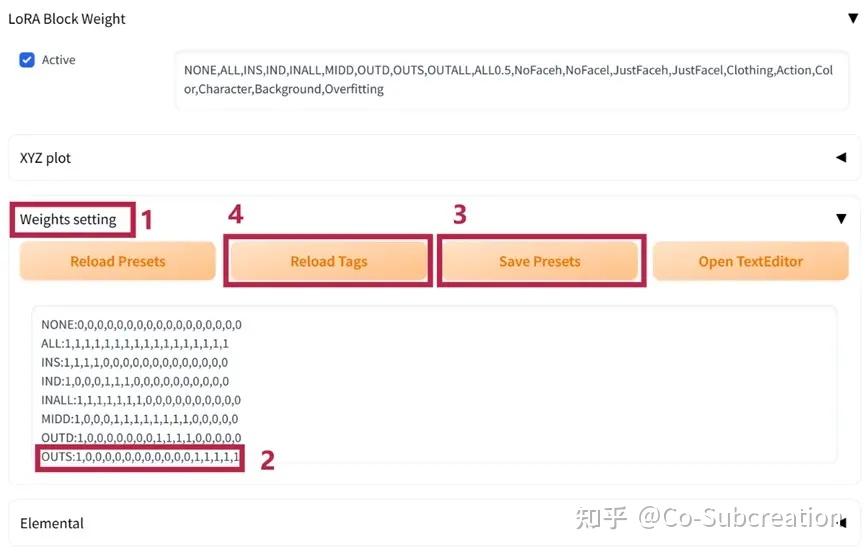

预设可以在【weights setting】(1)里本身设置,格式就是“预设名+半角冒号+分层权重”(2),改完点击【save presets】(3),再点击【reload tags】(4)即可。

使用的时候就可以改成<LoRA名:总权重:预设名>,如<LoRA:Style_GlassyandGlaze (FATA)_v1.0:1: Color>,而不必输入整串权重。

不外这样保留下来的图片信息就只有预设名,不便利他人使用,不利传布。所以建议保留整串权重,也便利随时改削。大师可以把预设当备忘录。

权重共有17层,简单说,前段影响衣服和布景,中段影响动作与脸,后段影响画风。

关于LoRA Block Weight的道理和其他预设参数,可以看:

@大江户兵士 【AI绘画】LoRA进阶用法:分层控制

https://www.bilibili.com/video/BV1Wv4y157NH/ 1.4.3. PART 3 高清修复

方针:让图片变成高分辩率。

多次调整参数对比修复成果之后,图片达到一个还算可以的程度,拖到【附加功能】标签页(1)里,设置好参数(2、3)点击【生成】(4),就可以得到一张4k高清图了~

关于Upscaler分歧的参数,可以参考:

@秋葉aaaki 【AI绘画】老婆2秒一键变高清!图片放大教程 AI重画拯救超低分辩率图片 NovelAI

https://www.bilibili.com/video/BV1ne411A7TJ/ 1.5. 分袂说说它的长处和错误谬误

1.5.1. 长处

▶ 非常适合可以直接使用大量提示词按需精准出图的大佬,可以充实阐扬在提示词方面的极大优势,出图迅速。

▶ 能够斗劲完整的保留图片信息,便利下次继续使用或复刻。

▶ 门槛低,简单便利易上手,只要没有特殊要求,任何人都能跑出整体斗劲都雅的图。

1.5.2. 错误谬误

▶ 纯挚使用局部重绘进行改削,费时吃力且效果不佳。

▶ 构图、角色动作、布景环境随机性大,不易控制。

▶ 基本没有插件参与,不适合跑多人图。

<hr/>2. AI参与度70%

2.1. 请用一句话概括它

深度图+骨骼图控制画面布局与角色动作,可跑多人图。

2.2. 它适合我用吗?

如果缔造者认领以下任何标签之一,那么就可以测验考试使用这种方式:

▶ 需要复刻某张图的布局

▶ 想制作多人图

▶ 需要把握画面布局,控制角色动作

▶ 玩梗、恶搞

2.3. 请展示一下成果

parameters1girl, solo, nahida_genshin,(((((cross-shaped pupils))))),<lora:yetAnotherNahidaGenshin_nahidAV3:0.9>Negative prompt: EasyNegative, badhandv4Steps: 20, Sampler: DDIM, CFG scale: 8, Seed: 1685908459, Size: 1600x640, Model hash: a074b8864e, Model: C2_B_Counterfeit-V2.5_pruned, Denoising strength: 0.75, Clip skip: 2, ENSD: 31337, Mask blur: 4, ControlNet-0 Enabled: True, ControlNet-0 Module: none, ControlNet-0 Model: control_depth-fp16 [400750f6], ControlNet-0 Weight: 1.1, ControlNet-0 Guidance Start: 0.2, ControlNet-0 Guidance End: 1postprocessingPostprocess upscale by: 2, Postprocess upscaler: ESRGAN_4x

2.4. 具体要怎么做?

2.4.1. PART 1 前期筹备

方针:下载好模型,寻找到素材,安装、配置好相关插件。

2.4.1.1. 模型选择

增加了一个角色LoRA的使用:

Rukkhadevata/大慈树王 TI+LORA Anime/Realistic Genshin 原神(id:28703)

2.4.1.2. 素材搜集

使用到的素材:

▶ 一张想要仿照布局的参考图

▶ 源自该参考图的骨骼图

为了减少争议与纠纷,建议拔取:

可免费商用的图片

doyoudo的资源导航

https://www.doyoudo.com/resources

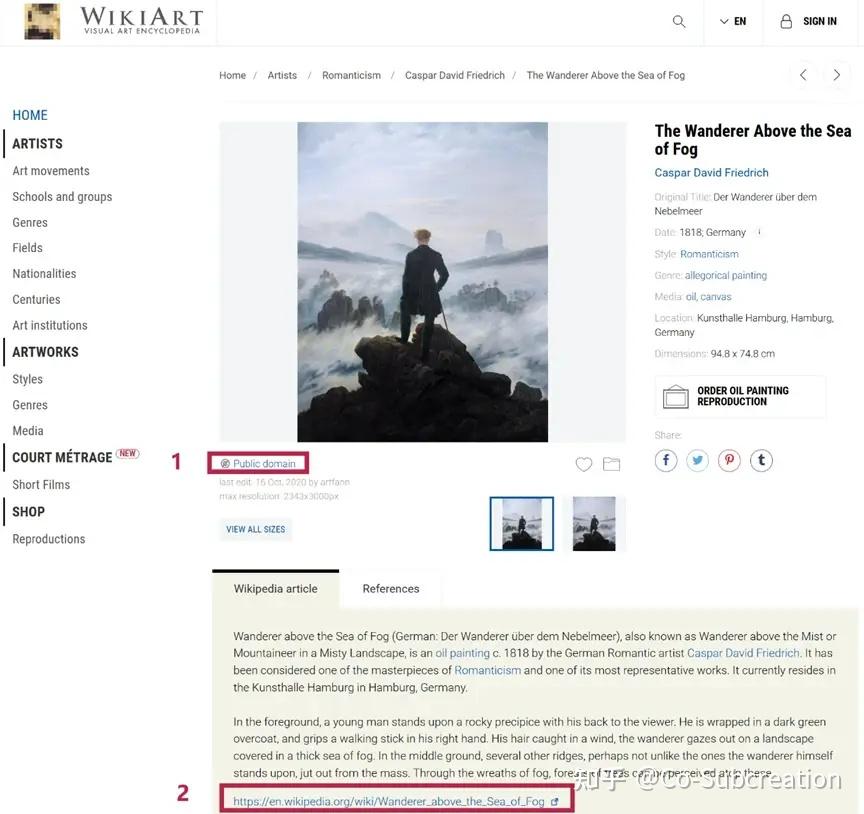

已无著作权庇护的世界名画。

WikiArt

https://www.wikiart.org/ 版权说明(1)在图片下方,高清图点击Wikipedia链接(2)下载即可。

因为使用深度图的关系,画面布局基本是1:1复制的,所以建议谨慎拔取诸如Pinterest、小红书、花瓣等属于用户个人收集类图片。

我们此次只做绘制同人图使用,参考图选择的是米开朗基罗的缔造亚当。

2.4.1.3. 插件拔取

本方式使用到的插件有:

▶ ControlNet

用于骨骼图、深度图的加载与使用。(最新秋叶大佬整合包v4已预置)

https://github.com/lllyasviel/ControlNet-v1-1-nightly ControlNet模型下载

https://huggingface.co/lllyasviel/ControlNet-v1-1/tree/main ▶ Openpose Editor

用于在平面内调整人物骨骼,产出可用的骨骼图。

https://github.com/fkunn1326/openpose-editor ▶ Latent Couple

用于实现多人同框

https://github.com/opparco/stable-diffusion-webui-two-shot ▶ Composable LoRA

用于防止多LoRA彼此污染

https://github.com/opparco/stable-diffusion-webui-composable-LoRA 2.4.1.4. ControlNet插件多开配置

在【设置】标签页(1),【ControlNet】选项卡(2)下,调整【Multi ControlNet 的最大网络数量】滑块参数(3)。数量看具体需求,一般3个就够用了。点【保留设置】(4)后,【重启 WebUI】(5)。

2.4.1.5. 骨骼图制作(Openpose Editor)

在【OpenPose 编纂器】标签(1)下,点击【Detect from Image】(2),加载参考图。

自动识此外只有一套骨骼,点击【添加】(1)再添加一套。调整骨骼和分辩率(2),点击【保留为 PNG图片】(3)备份骨骼图,点击【>>文生图】(4)。

2.4.2. PART 2 文生图

方针:跑出一张整体还不错的基本图。

2.4.2.1. ControlNet插件使用

2.4.2.1.1. 骨骼图使用

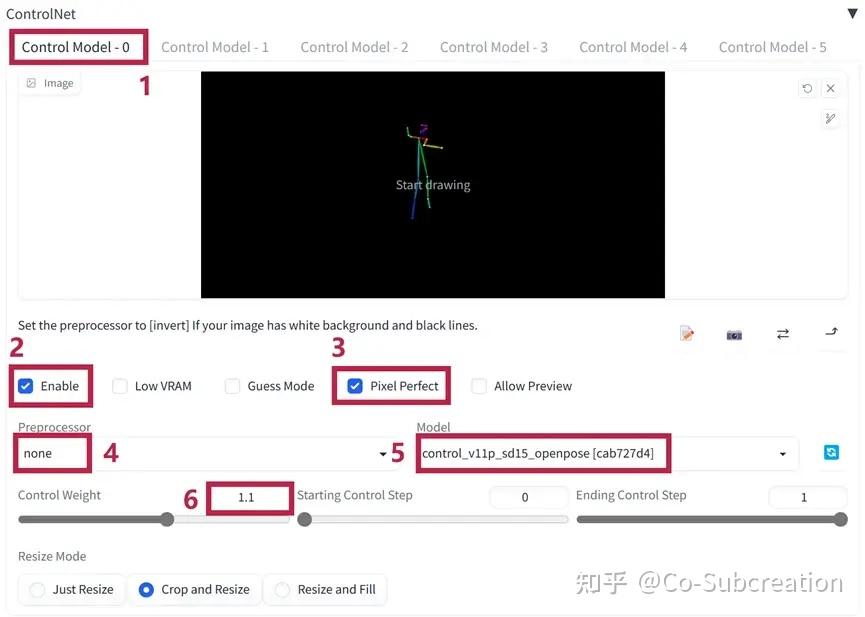

来到【文生图】的【ControlNet】,【Control Model - 0】标签(1)勾选【启用】(2),【Pixel Perfect】(3)。

设置如图:预措置器为无(4),模型选openpose(5),权重(6)可以按照需求调节。

2.4.2.1.2. 深度图使用

【Control Model - 1】标签(1)勾选【启用】(3),【Pixel Perfect】(4),拖入参考图(2)。

设置如图:预措置器为【depth zoe】(5),模型选【depth】(6),权重(7)按需来。

2.4.2.2. 可自组LoRA的使用(Composable LoRA)

勾选【启用】即可。

2.4.2.3. 潜变量成对的使用(Latent Couple)

勾选【启用】。

在【蒙版】标签页中,拖入参考图。把此中一个人涂黑,点击【I've finished my sketch】。

在General Prompt中输入未涂黑部门的提示词(1),在Prompt for this mask中输入涂黑部门的提示词(2),点击【Prompt Info Update】(3),设置好宽高(建议把例图实际尺寸等比缩小)。

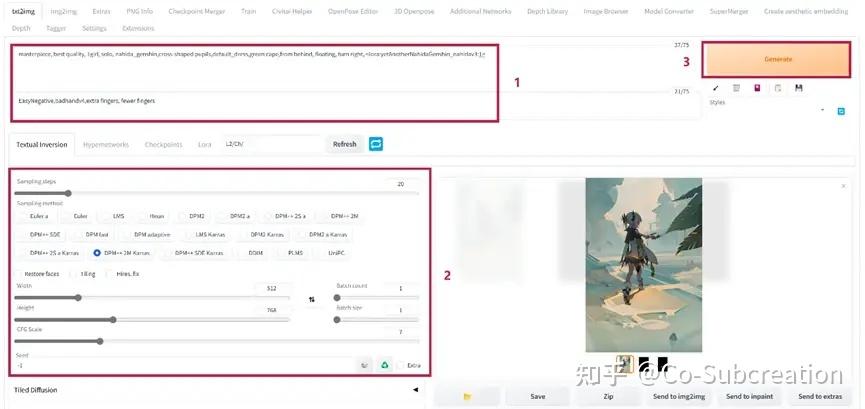

2.4.2.4. 后续设置

可以看到提示词(1)部门已经自动同步了,不要改动格式。如果需要改动提示词,建议回到【潜变量成对】插件中改动防止混乱,改完同样点击【Prompt Info Update】即可。

按照本身的偏好设置好其他参数(2),开始跑图(3)。

如果想跑3人及以上的图,需要进入【潜变量成对】插件的Rectangular标签,具体参数配置可参考

@大江户兵士 【AI绘画】画出本身想要的CP图/多人图:Latent couple、Composable LoRA以及ControlNet的搭配使用

https://www.bilibili.com/video/BV1UY4y1U7jX 2.4.3. PART 3 图生图

方针:提高单张图质量。

法式与AI参与度100%时的基本一致。

需要注意的是,【可自组LoRA】和【潜变量成对】两个插件依然需要延续part2文生图的设置,但【ControlNet】可以不使用,让AI自动修补一下不合理的处所。

演示一下,比如这张图,左下角的纳西妲被骨架图和深度图强行拉伸了体型。

图生图里调低重绘幅度,不使用【ControlNet】,就会按照LoRA把纳西妲的体型改的正常一点。

对图像质量要求斗劲高的缔造者可以按照角色体型调整骨骼,在图生图部门单独使用骨骼图。(深度图就不要放了,调整后的骨骼与原参考图纷歧致,但深度图无法随之调整,会打架。)

2.4.3.1. 挑选图生图适用图片的小技巧

需要顾忌的处所:

▶ 肢体数量

▶ 动作

▶ 环境色彩

▶ 构图

不需要顾忌的处所:

▶ 面部崩坏(自动修复,或去除可疑LoRA,或局部重绘)

▶ 表情奇怪(自动修复,或去除可疑LoRA,或局部重绘)

▶ 过饱和(可通过改变分辩率解决)

▶ 不太像方针角色,服饰错误(可通过提高LoRA权重解决)

2.5. 分袂说说它的长处和错误谬误

2.5.1. 长处

▶ 可以跑多人图

▶ 可以控制整体布局和人物动作

▶ 能够斗劲完整的保留图片信息,便利下次继续使用或复刻

▶ 门槛较低,不需要掌握较为专业的其他范围的常识

2.5.2. 错误谬误

▶ 缺乏细节控制

▶ 布景环境随机性大

▶ 纯挚使用局部重绘进行随机改削,费时吃力且效果不佳

▶ 画面合理性有斗劲大的欠缺

<hr/>3. AI参与度50%

3.1. 请用一句话概括它

AI语义分割+骨骼+手脚深度图完全控图,人工ps修图。

3.2. 它适合我用吗?

如果缔造者认领以下任何标签之一,那么就可以测验考试使用这种方式:

▶ 对构图有必然了解,需要构图的自由度

▶ 想要在不完全借鉴参考图的前提下,把握画面布局,控制角色动作

▶ 想要按照本身心意摆放角色、替换布景

▶ 有修图基础,需要修图来保证图片质量

▶ 需要做前期概念图

3.3. 请展示一下成果

parametersfeet,from behind,masterpiece, best quality, 1girl, solo, nahida_genshin,cross-shaped pupils,default_dress,green cape, <lora:yetAnotherNahidaGenshin_nahidAV3:1>Negative prompt: EasyNegative,badhandv4,extra fingers, fewer fingersSteps: 20, Sampler: DPM++ 2M Karras, CFG scale: 20, Seed: 3428597529, Size: 1024x1536, Model hash: a074b8864e, Model: C2_B_Counterfeit-V2.5_pruned, Denoising strength: 0.5, Clip skip: 2, ENSD: 31337, Mask blur: 4, Dynamic thresholding enabled: True, Mimic scale: 10, Threshold percentile: 100, CFG mode: Half Cosine Up, CFG scale minimum: 3

3.4. 具体要怎么做?

3.4.1. PART 1 前期筹备

方针:确定主题,收集素材,安装、配置相关插件。

3.4.1.1. 主题构思

▶ 角色:纳西妲单人+龙

▶ 布景:废墟,可以有压迫感,但焦点必需在纳西妲身上

▶ 构图:反正皆可,最好不要太无趣

▶ 元素:主线中的“火种”,最好有一点点特效

▶ 其他要求:纳西妲在整个画面占比可以小一点,但不能看不清楚

3.4.1.2. 素材搜集

使用到的素材:

▶ 一张或多张可以参考构图的图片

▶ 一张或多张人物动作图片或人物骨骼图

人物动作图片可以从操练速写用的人体网站寻找;

Line-of-actionhttps://line-of-action.com/

Motionshttps://www.bodiesinmotion.photo/motions

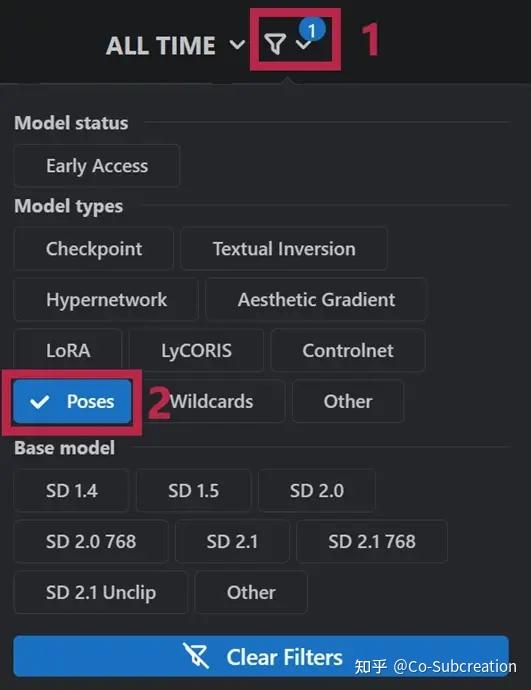

也可以在模型站搜索现成的骨骼,筛选poses,挑本身喜欢的下载;

或者使用3D人体模型摆本身喜欢的动作。

无限人偶http://www.pofiapp.com/

DesignDollhttps://doll-a.net/terawell/

3.4.1.3. 插件拔取

本方式使用到的插件有:

▶ ControlNet

用于语义分割图、骨骼图、手脚深度图的加载与使用。

▶ 3D Openpose Editor

用于在3d里调整人物骨骼,产出可用的骨骼图。(也提供网页版,可在线编纂)

(用不惯可以继续使用Openpose Editor)

https://github.com/nonnonstop/sd-webui-3d-open-pose-editor 3D Openpose Editor在线版-点【Click me to get editor】

https://github.com/ZhUyU1997/open-pose-editor ▶ Dynamic Thresholding (CFG Scale Fix)

用于高CFG时花图的修复。

非必需,可不用。

https://github.com/mcmonkeyprojects/sd-dynamic-thresholding 关于骨骼编纂器的选择:

Openpose Editor是平面骨骼图,直接拖拽关节点即可完成骨骼调整,简单快捷。

3D Openpose Editor是3d骨骼图,通过xyz动弹实现骨骼调整,自由度较高,但不易上手,适合会一点3d基础操作的缔造者。

建议大师按照本身的实际需求选用。

3.4.1.4. 骨骼图制作(3D Openpose Editor)

这里演示的是DesignDoll和3D Openpose Editor的搭配使用,流程斗劲复杂,但操作空间大,自由度高。

DesignDoll软件本身是付费的,但官方动作参考中的预览图是免费的。

Doll Atelier

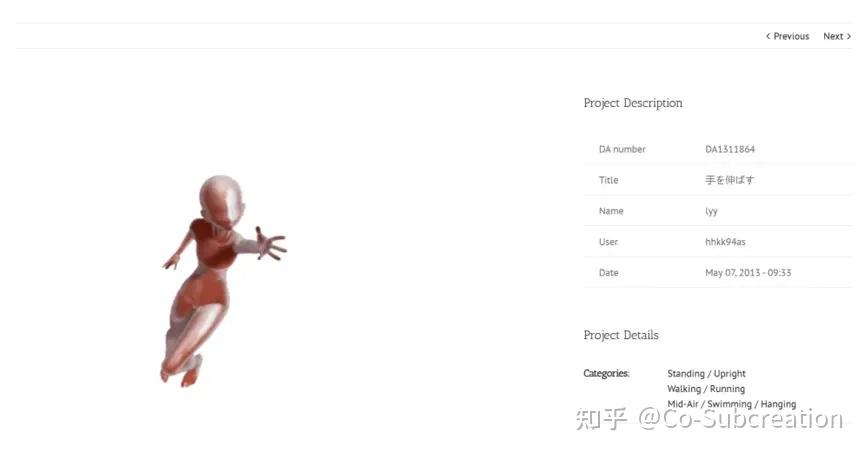

https://doll-a.net/terawell/ 在首页下拉选择需要的动作分类。

或者在右上角搜索栏进步履作检索。

搜索撑持日文,但由于日文里凡是带有汉字,所以对国人来说可以直接使用某个动作的单字进行搜索(比如手を伸ばす的意思是伸手,单搜“伸”,也是能够搜索出伸手动作的,比查翻译要便利)。

鼠标滑动到与预期动作差不多的动作预览上,点击左边【圆形链接】图标。

下载预览图片。

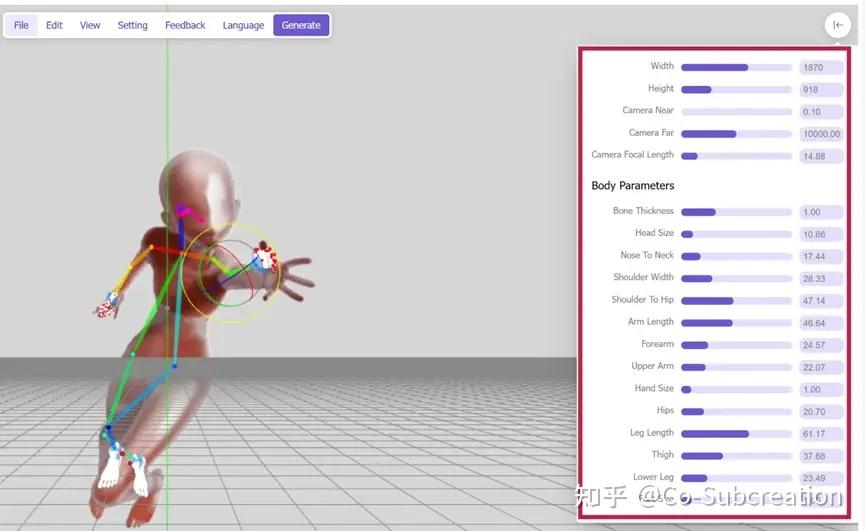

在webUI里使用【3D Openpose Editor】插件(1),,插件内右边【language】(2)可以改中文。点击【文件】(3) – 【从图片中检测】(4)

调整自动识别出的骨骼为本身想要的动作。

(基础调节:长按左键旋转视角,长按右键移动视角,滚轮缩放视角。点选彩色线段,调整骨骼绕关节点xyz轴旋转。右侧参数可调整某段骨骼长短。)

☆不小心重启webUI了,再打开可以测验考试点击【恢复上次场景】来继续编纂。

改好之后点【生成】,会自动跳转到【发送到 ControlNet】标签(1)。

下载骨骼(2)和手脚深度图(3)存档,点击【>>文生图】(4)。

转到文生图,设置如图。【ControlNet】插件【Control Model – 0】标签页(1)勾选【启用】(2),【Pixel Perfect】(3),预措置器为无(4),插件模型为骨骼(5),调整权重(6)。(仅骨骼即可,最多加一个手脚的深度图)

增加提示词(1),概略调一下设置(2),测验考试生成角色(3)。

效果还不错,大体是我们需要的姿势,保留这张图。(这里的图不需要细调)

3.4.1.5. 语义分割图的制作(ControlNet1.1)

按照主题,我们从之前提到的免费图片库Unsplash中找到了这两张图,筹算结合一下。

Unsplash

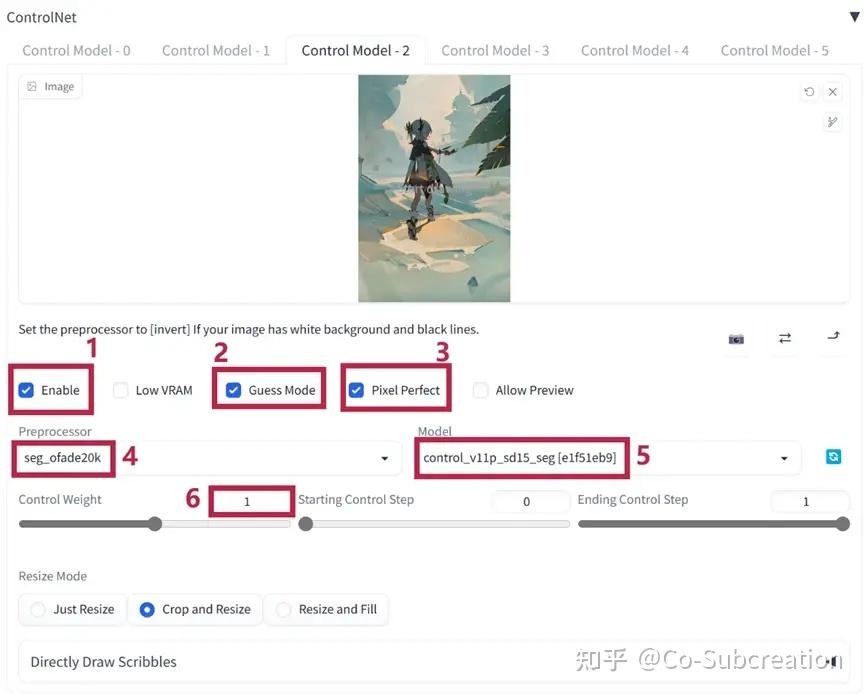

https://unsplash.com/ 把两张参考图和方才生成的角色图分袂拖入文生图的ControlNet三个标签中,设置都一样,如图所示。勾选【启用】(1),【无提示词模式】(2),【Pixel Perfect】(3),预措置器选择seg_ofade20k(4),模型选择seg(5)。

如果缔造者下载的是秋叶大佬的整合包,那么有可能没有ControlNet可用的seg模型,需要先去huggingface下载:

https://huggingface.co/lllyasviel/ControlNet-v1-1/tree/main 放到启动器根目录的\models\ControlNet里。

不用写提示词(1),调整好宽高(2),点击生成(3)。保留跑出的三张语义分割图(4)。

把保留的语义分割图和骨架图拖进PS里(或者任何图片编纂东西)。

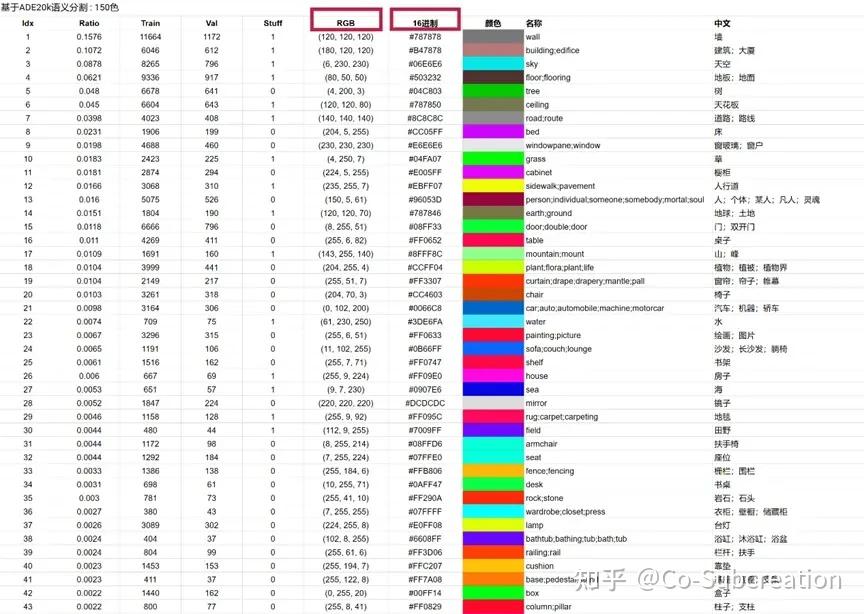

使用画笔东西按照“基于ADE20k语义分割-150色”的颜色改削图片。(以RGB颜色值和16进制颜色码为准)

-中文在线版,google云盘

https://docs.google.com/spreadsheets/d/e/2PACX-1vTHnI4vMtYyNgYEtk38BKSH2vfn1P1xwnC75XdhxZHokZ8j0zCW1TKA8qUwzs2AX3giXkuRLdyfavId/pubhtml

(源自@AugmentedRealityCat https://github.com/Mikubill/sd-webui-ControlNet/discussions/445)

-中文下载版

@大江户兵士 【AI绘画】强大的构图东西:Seg(ControlNet)语义分割控制网络(简介里)

https://www.bilibili.com/video/BV1bM411x7nD

改完后拉低透明度看看骨骼图和手脚深度图能不能跟语义分割图正常对上。

3.4.2. PART 2 文生图

方针:跑出一张整体还不错的基本图。

把语义分割图、骨骼图、手脚深度图分袂保留为三张大小一致的图片。

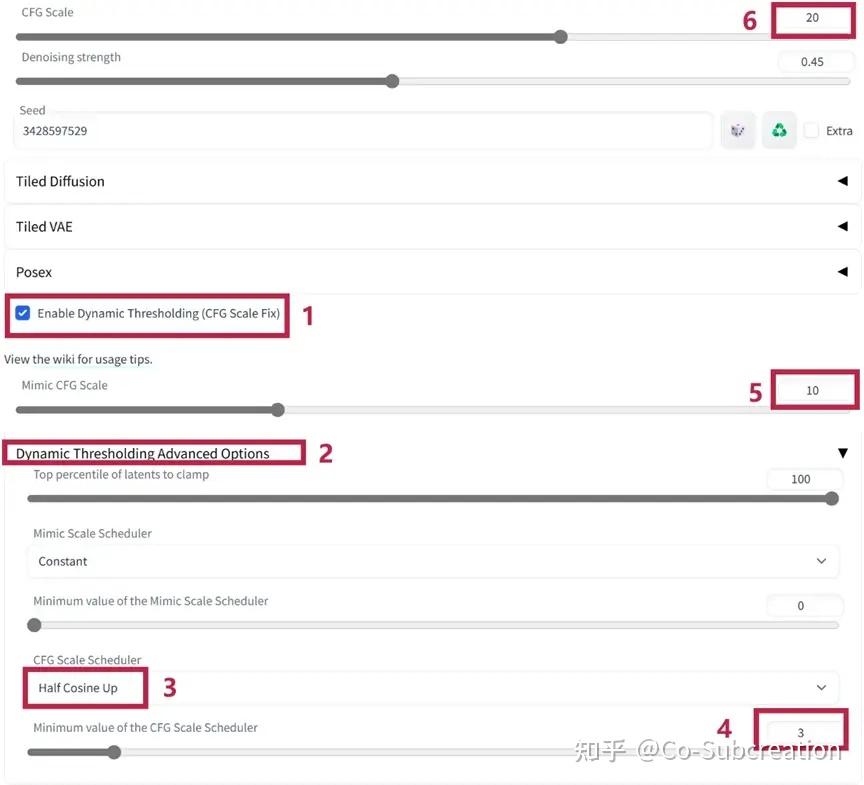

文生图【ControlNet】里,【Control Model - 0】标签页(1)放语义分割图(2),模型选seg(6),勾选【Pixel Perfect】(4);【Control Model - 1】标签页放骨骼图,模型选openpose;【Control Model - 2】标签页罢休脚深度图,模型选depth。其他设置都一样,预措置器都是无,权重按照跑图效果调。

调整提示词和其他设置,开始跑图。

挑选一下跑出来的图就可以拉进图生图了。

3.4.3. PART 3 图生图

方针:提高单张图质量。

可以延续之前图生图的方式,在这一步里插手画风LoRA。

如果想要保持构图和角色动作不变,依然需要用到语义分割图、骨骼图、手脚深度图来控制。权重可以按照需要设置的低一点,让AI全方位美化一下。

对于演示的图片,我们的需求是保留整体构图、优化角色动作,所以设置的权重依次是1.0,0.4,0.6。

这时候前期如果做的没问题,选题不是太放飞,基本就可以出图了,而且手脚眼基本都不会有太大问题。

如果手还是有问题,需要单独修,或者想要换一个手部动作。

用ControlNet简笔画版请看

@大江户兵士 【AI绘画】如何简单又快速地操作ControlNet修手

https://www.bilibili.com/video/BV1Ej411g7R4/ 使用depth libray插件深度图版请看

@AI次世代 【AI绘画进阶教程】姿势自由_骨骼读取_手部动作 ControlNet软件好辅佐 openpose插件✓ posex插件✓ Depth Library✓

https://www.bilibili.com/video/BV17L411k7Zu/ 3.4.4. PART 4 PS修图+图生图(非必需)

方针:精修出一张合理、精致的图。

3.4.4.1. PS修图

首先说明,这一步需要一点PS基础哦~

好的,让我们挑选一张稍微好一点的图,拉进PS里,改削一下不合理的处所。

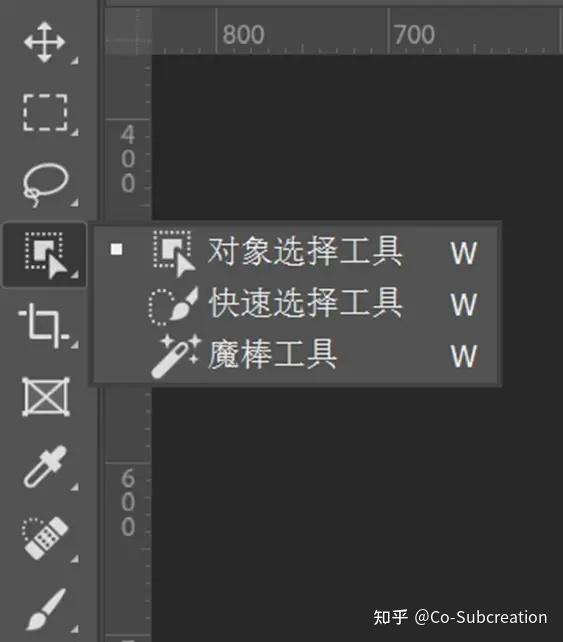

指定使用PS进行修图,是因为新版PS抠图非常便利。PS2023里也插手了语义识此外功能。在界面左侧东西栏,右键点击【魔棒东西】,(套索下面阿谁,别管它默认叫什么)选择【对象选择东西】。

鼠标滑过,语义识别到同组会变粉,点击要调整的主体,即可选中。

选中的状态下,在左侧东西栏选择【矩形选框东西】,按住Alt,框选不需要的部门,即可减去其他选区,只留需要选择的部门。

比如这里只需要调整小腿。

改削的时候记得保留一下原图,多建几个图层。

只需要涂色块即可,不需要做太细。嫌麻烦可以把之前跑出来的局部斗劲好的图替换上。

调完后的空白区域怎么办呢?还记得之前保留的原图吗?再复制一层,先关掉改削图的显示,依然通过对象选择东西选择主体,点击右键选择删除和填充选区。

看一眼效果

布景层+改削后的图

改削完成,另存为一张新图。(注意不要覆盖导致原图丢掉)

3.4.4.2. 图生图

使用原图的图片信息和种子+调整好的图。

注意,这里的设置建议使用【拉伸】,而非【直接缩放 (放大潜变量) 】,重绘幅度调小一点。

由于角色动作有变换,所以就不再使用骨骼图和深度图了,只留语义分割,权重调低。

对图像要求斗劲高的缔造者可以从头做一张骨骼图和手脚深度图。

这一步就不要在提示词里新增风格LoRA了,否则白干警告。

如果图生图实现不了需求,可以使用局部重绘一点一点调,与之前的方式里提到的一样。

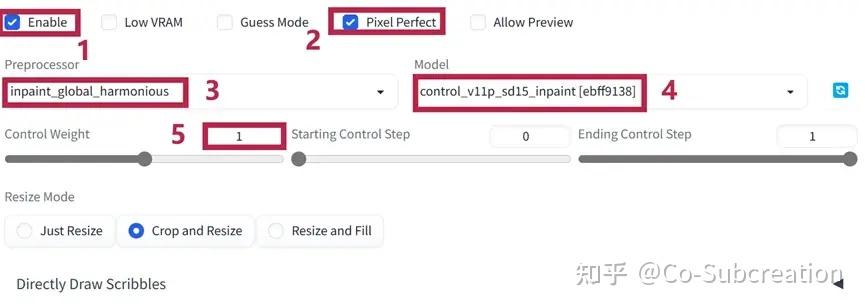

此外,ControlNet1.1版本中插手了局部重绘模型,可以搭配使用提高效果。设置如图,预措置器选择inpaint,模型inpaint。

3.4.4.3. 动态阈值的使用Dynamic Thresholding (CFG Scale Fix)

由于修复的时候经常容易把提示词给修没,就需要拉高CFG,而纯挚拉高容易导致画面过饱和,所以需要CFG修复来平衡。常用参数设置如下:勾选【启用动态阈值(提示词相关性修复 - CFG Scale Fix)】(1),在【高级选项】(2)中,【CFG Scale Scheduler】选择【Half Cosine Up】(3),【Minimum value of the CFG Scale Scheduler】滑块数值(4)在2~4之间。

注意【模拟提示词相关性(Mimic CFG Scale) 】(5)不要与【提示词相关性(CFG Scale) 】(6)相差过大(超过10)。

3.5. 分袂说说它的长处和错误谬误

3.5.1. 长处

▶ 可以实现场景、构图、角色动作全控

▶ 可以调整更多细节

3.5.2. 错误谬误

▶ 最终成图无图片信息

▶ 寻找素材、反复修图斗劲费时吃力

▶ 需要有必然ps基础

▶ 画面合理性依然有欠缺

<hr/>4. AI参与度30%

4.1. 请用一句话概括它

人工传统绘画草稿+线稿+底色,AI细化上色。

4.2. 它适合我用吗?

如果缔造者认领以下任何标签之一,那么就可以测验考试使用这种方式:

▶ 有至少达到行业尺度的绘画基础

▶ 需要做角色&立绘设计(不包含普通OC,普通OC可以使用三视图LoRA随机出)

▶ 懒得上色

4.3. 请展示一下成果

parameters(Masterpiece, best quality, extremely detailed CG, highly detailed, 8k wallpaper, Ultra HD_ 1.2),1girl, solo, smoking pipe, japanese clothes, red kimono,kiseru, smoke, kimono, hair ornament, breasts, hair stick, off shoulder, bare shoulders, cleavage, kanzashi, holding smoking pipe, closed eyes, holding, collarbone, standing, full body, sash,Negative prompt: EasyNegative, badhandv4Steps: 20, Sampler: DPM++ 2M Karras, CFG scale: 7, Seed: 2437440079, Size: 1280x1920, Model hash: a074b8864e, Model: C2_B_Counterfeit-V2.5_pruned, Denoising strength: 0.5, Clip skip: 2, ENSD: 31337, ControlNet-0 Enabled: True, ControlNet-0 Module: lineart_standard (from white bg & black line), ControlNet-0 Model: control_v11p_sd15s2_lineart_anime [3825e83e], ControlNet-0 Weight: 0.7, ControlNet-0 Guidance Start: 0, ControlNet-0 Guidance End: 1, ControlNet-1 Enabled: True, ControlNet-1 Module: none, ControlNet-1 Model: control_v11p_sd15_openpose [cab727d4], ControlNet-1 Weight: 1, ControlNet-1 Guidance Start: 0, ControlNet-1 Guidance End: 1

parameterswings, ((solo)), long hair, white background, barefoot, feathered wings, holding, multiple wings, simple background, blonde hair, angel, angel wings, gold, book, full body, halo, jewelry, white wings, 1girl, white hair,Translucent,backlightNegative prompt: EasyNegative, badhandv4Steps: 20, Sampler: DPM++ 2M Karras, CFG scale: 17, Seed: 2036563997, Size: 1536x1280, Model hash: a074b8864e, Model: C2_B_Counterfeit-V2.5_pruned, Denoising strength: 0.7, Clip skip: 2, ENSD: 31337, Mask blur: 4, ControlNet-0 Enabled: True, ControlNet-0 Module: none, ControlNet-0 Model: control_openpose-fp16 [9ca67cc5], ControlNet-0 Weight: 1, ControlNet-0 Guidance Start: 0, ControlNet-0 Guidance End: 1, ControlNet-1 Enabled: True, ControlNet-1 Module: canny, ControlNet-1 Model: control_canny-fp16 [e3fe7712], ControlNet-1 Weight: 0.3, ControlNet-1 Guidance Start: 0, ControlNet-1 Guidance End: 1, Dynamic thresholding enabled: True, Mimic scale: 7, Threshold percentile: 100, CFG mode: Half Cosine Up, CFG scale minimum: 3

4.4. 具体要怎么做?

4.4.1. 插件拔取

本方式使用到的插件有:

▶ ControlNet

用于lineart和骨骼图的加载与使用。

▶ Tagger

用于草稿&线稿图提示词的反推。(最新秋叶大佬整合包v4已预置)

https://gitcode.net/ranting8323/stable-diffusion-webui-wd14-tagger 4.4.2. PART 1 文生图

方针:跑出一张还可以的基本图。

这里拿我们的一位缔造者伙伴之前画的1张半成品线稿,和1张完成度斗劲高的已完成底色的画来举例(已授权)。

把图片(2)拖进【Tag反推(Tagger)】插件(3)里【开始反推】(2)提示词,完成后点击【>>文生图】(4)。

有底色的这张也可以直接【>>图生图】(1),区别就是需不需要带氛围。

注意看一眼提示词(2)里有没有带着线稿、黑白稿之类的tag,以及与画面本身冲突的tag,把它们删除。

使用完成跋文得点击【卸载显存中所有反推模型】(3)卸载模型释放显存。

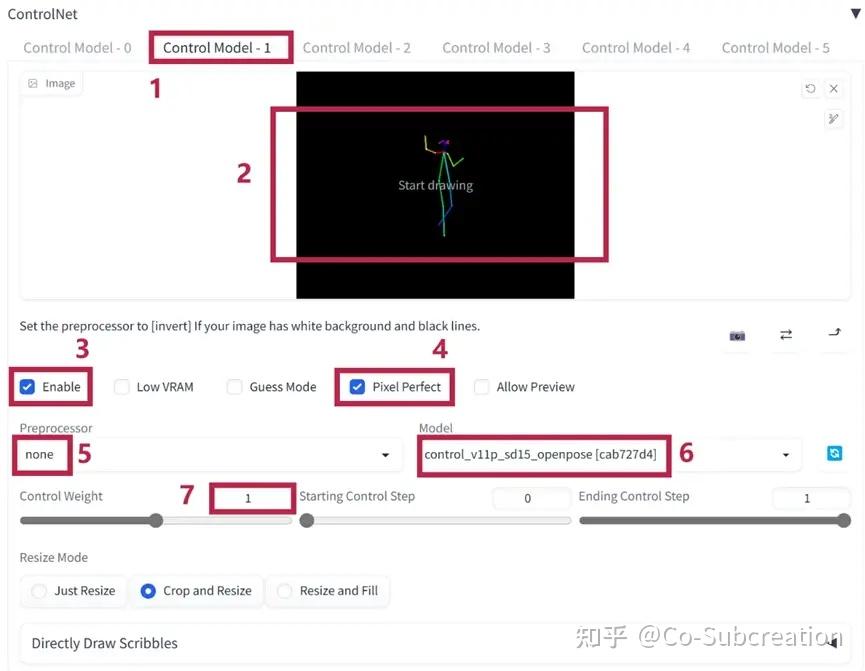

ControlNet【Control Model - 0】(1)放线稿图(2),勾选【启用】(3),勾选【Pixel Perfect】(4)。预措置器为lineart standard(5),模型为lineart anime(6)。

(如果缔造者下载的是秋叶大佬的整合包,那么有可能没有ControlNet1.1可用的lineart anime模型,需要先去huggingface下载,放到启动器根目录的\models\ControlNet里。)

【Control Model - 1】放骨骼图,设置与之前的方式一致,不再多说了。

已上好底色的图,预措置器(5)可以选择lineart anime,模型(6)选择lineart anime。

调整好文生图其他设置,跑图。

4.4.3. PART 2 图生图

方式如前述,挑选一张称心如意的图。

线稿权重可以稍微拉低,跑图。

这里放一下在图生图里有没有ControlNet参与的对比效果图。

只有提示词

骨骼图

骨骼图+线稿

有底色的放两张直接图生图和文生图+图生图的对比效果图。

图生图

文生图+图生图

都雅,但不还原,需要寻找更合适的底模和LoRA(比如可以画御姐的)。

所以如果使用AI,就不建议板绘前期画太细了。(白干警告!)

4.5. 分袂说说它的长处和错误谬误

4.5.1. 长处

▶ 节省繁重上色的时间。

▶ 如果模型用得好,可以实现全控。

4.5.2. 错误谬误

▶ 复杂一点的线稿基本无法复原。

▶ 需要专业绘画基础。

▶ 需要挑选适合的模型,以达到预期的画风。 |

本帖子中包含更多资源

您需要 登录 才可以下载或查看,没有账号?立即注册

×

|